ACTU

Nvidia passe le test de Turing

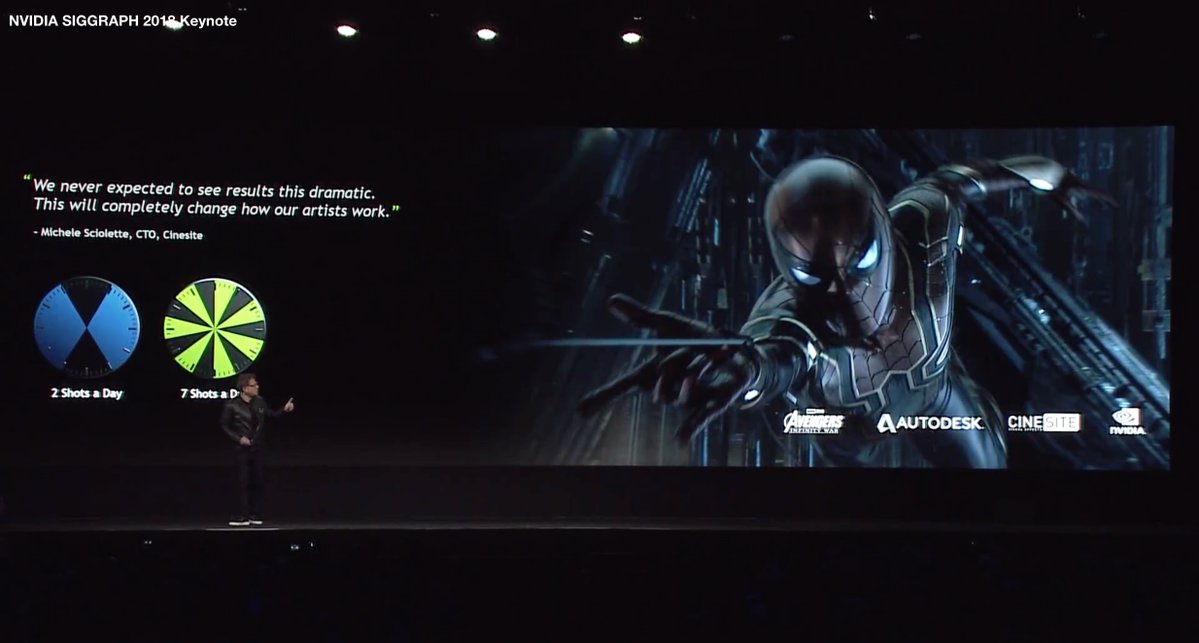

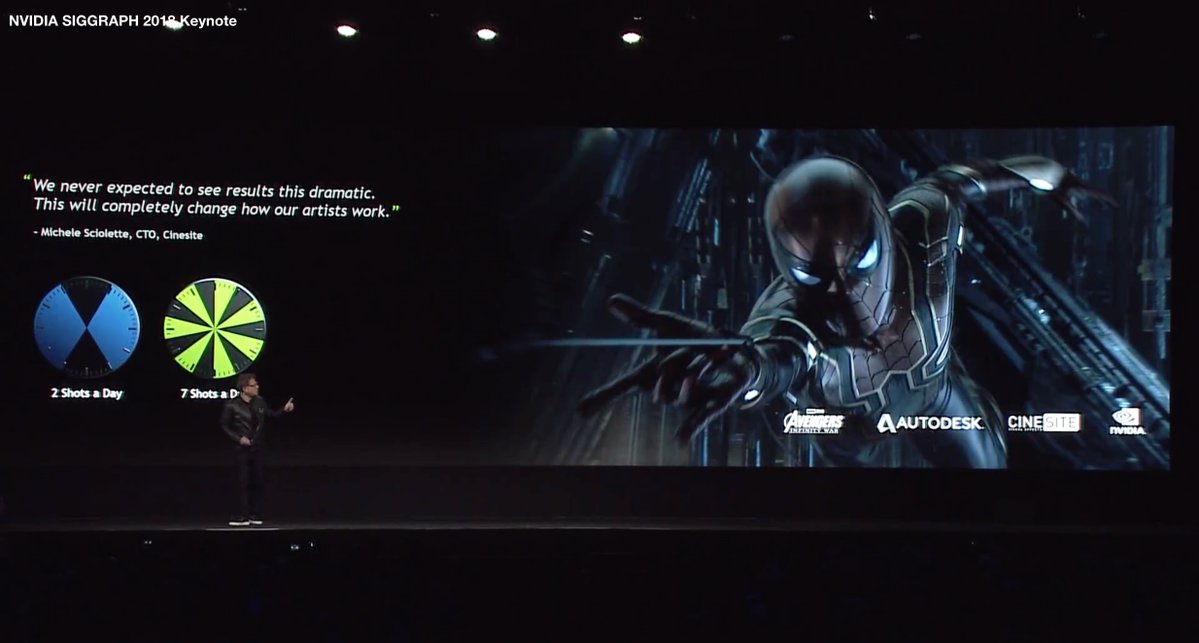

Lors de la précédente GTC, Nvidia et Microsoft nous avaient teasé leur nouvelle API dédiée au ray-tracing temps réel. Si les démos étaient impressionnantes, on se demandait bien sur quelle carte ça pouvait bien tourner. Nous avons désormais la réponse : dévoilée au Siggraph (Special Interest Group on Computer GRAPHics and Interactive Techniques, conférence annuelle autour du thème des technologies de l'image), la Quadro RTX annonce ce que sera la nouvelle génération de carte de la société américaine.

Nous avons donc pu voir un Jen-Hsun Huang (PDG de Nvidia) tout heureux de nous présenter Turing, nouvelle architecture de GPU succédant à Pascal (Quadro GP10x et GTX 10x0) et Volta (Quadro GV100 et Titan V) et annoncée comme la plus grosse révolution depuis l'avénement de CUDA. Et effectivement, cette carte a tout sous le capot pour lancer des millards de rayons à la seconde - plus exactement 10 Gigaray/s, soit 10.000.000.000 par seconde, pour la plus grosse carte.

Quel est l'interêt me direz-vous ? Est-ce que ce n'est pas encore une technologie tape-à-l'oeil vouée à disparaitre ? Tachons d'éclaircir ce qui peut l'être.

Outre la puissance de calcul offerte par Turing, Nvidia propose le NV-link, que l'on pourrait considérer comme du SLI 2.0 : Jusqu'ici, chaque carte ajoutée dans un PC pouvait, au mieux, échanger des données mémoire avec ses voisines. Une scène 3d devait être envoyée dans chaque carte pour pouvoir être rendue, mais chacune était responsable de sa propre image (et chaque carte calcule donc une image ou un oeil sur deux). Avec le NV-Link, la mémoire de chaque carte est partagée, évitant cette redondance d'informations, et permettant d'additionner la mémoire disponible sur chacune.

En clair : Si vous aviez 2 cartes avec 12 Go de ram, vous aviez au total 12 Go de ram, et l'obligation d'envoyer les données 2x. Désormais, vous aurez 24 Go de ram, et ne devez envoyer les données qu'une seule fois. Chaque carte peut de plus écrire en même temps dans la même image.

L'air de rien, rien que ce nouveau pont permet d'enlever une des plus grosse limite qui obligeait les renderer offline à bosser sur un CPU (une scène 3d un peu lourde, avec textures, peut prendre 64 Go de mémoire par exemple). Ici, c'est un maximum de 96 Go de ram qui peut etre alloué au total.

Vient ensuite les performances, le prix et la place. Il est évident que la place prise par une CG est bien moindre qu'un serveur complet. Il est aussi fort probable que la consommation électrique est bien plus faible. Pour les performances, si une seule Quadro RTX éclate sans problème n'importe quel Xeon, il reste à voir dans quel rapport puissance/prix. Nvidia annonce ici 10 GigaRay/s, mais le calcul d'intersection n'est qu'une faible partie du processus de rendu. Il faut encore résoudre des équations complexes pour arriver à une image finale. Nvidia annonce, à prix égal, un facteur de gain de 3 à 4x par rapport à un rendu CPU, ce qui est déjà énorme.

Ici aussi, l'architecture Turing essaie de faire tabula-rasa des techniques ancestrales, et propose, en plus de l'accélération hardware de RTX, des cores dédiés à l'IA (les TensorCore introduits par Volta) et à l'inférence (application d'un apprentissage via deep learning), afin de palier aux problèmes de temps de rendu du ray-tracing : on rend à moindre résolution et avec moins de rayons, et le deep learning vient retirer le bruit (problème majeur d'une image ray-tracing de faible qualité). Le DLAA (Deep Learning AA) s'applique actuellement dans les rendus précalculés via Optix.

Résultat : Là où une carte Pascal avait besoin de 600ms pour rendre une image, une carte Turing n'aura besoin que de 30 ms. Et nous parlons ici d'image complexe qui pourrait passer pour du rendu offline. Une image plus simple demandant évidemment moins de temps.

Tout ceci concerne les cartes professionnelles de Nvidia (gamme Quadro). Vous vous demandez sans doute quand est-ce qu'on aura ça pour le gaming. Probablement dans plusieurs années pensez-vous. Et bien pour répondre à cette question, Nvidia a, en parallèle de son annonce, diffusé un petit teaser sur youtube, avec quelques indices sur une possible nouvelle carte Geforce.

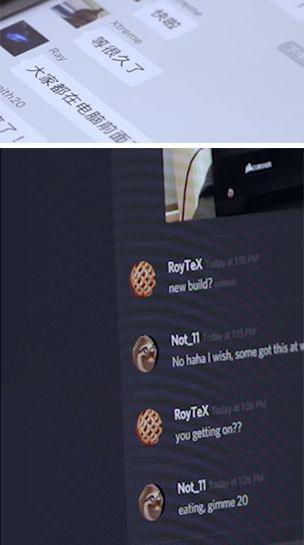

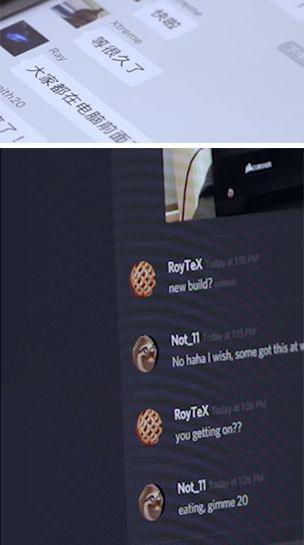

Xtreme Ray, RTX not 11, gimme 20.. Et un utilisateur Mac-20 parlant à un Eight Tee (Eighty = 80).

Pour marquer le saut de technologie, il semblerait que NVidia passe de la dénomination GTX 10x0 à RTX 20x0. A moins que les deux gammes co-existent ? Dans tous les cas, réponse le 20 août à la Gamescom ! Sinon, quelqu'un a pensé à prendre des nouvelles d'AMD ? Il a fait un peu chaud ces derniers jours et on s'inquiète un peu...

Nous avons donc pu voir un Jen-Hsun Huang (PDG de Nvidia) tout heureux de nous présenter Turing, nouvelle architecture de GPU succédant à Pascal (Quadro GP10x et GTX 10x0) et Volta (Quadro GV100 et Titan V) et annoncée comme la plus grosse révolution depuis l'avénement de CUDA. Et effectivement, cette carte a tout sous le capot pour lancer des millards de rayons à la seconde - plus exactement 10 Gigaray/s, soit 10.000.000.000 par seconde, pour la plus grosse carte.

Quel est l'interêt me direz-vous ? Est-ce que ce n'est pas encore une technologie tape-à-l'oeil vouée à disparaitre ? Tachons d'éclaircir ce qui peut l'être.

Où tu iras, j'I-ray.

L'industrie du film a depuis quelques temps abandonné le rasterizing (technique actuellement employée pour n'importe quel rendu temps réel 3d jusqu'ici), et le raytracing est devenu une technique standard. Quand on entend raytracing, beaucoup pensent "effets reflections". Mais c'est bien plus que ça : C'est une façon réaliste de calculer l'éclairage. Cette nouvelle Quadro vient donc avec toute une série d'outils et de SDK (notamment Optix) qui permettent aux moteurs précalculés (à l'opposé de temps-réel) tels que Arnold, Renderman, Vray, ... de booster leurs performances en tournant sur GPU. Ces outils sont déjà en place, notamment pour l'architecture (Revit) et le design (Solidworks). Encore mieux, Nvidia propose des outils permettant de faire cohabiter plusieurs logiciels au sein de son moteur de rendu.Outre la puissance de calcul offerte par Turing, Nvidia propose le NV-link, que l'on pourrait considérer comme du SLI 2.0 : Jusqu'ici, chaque carte ajoutée dans un PC pouvait, au mieux, échanger des données mémoire avec ses voisines. Une scène 3d devait être envoyée dans chaque carte pour pouvoir être rendue, mais chacune était responsable de sa propre image (et chaque carte calcule donc une image ou un oeil sur deux). Avec le NV-Link, la mémoire de chaque carte est partagée, évitant cette redondance d'informations, et permettant d'additionner la mémoire disponible sur chacune.

En clair : Si vous aviez 2 cartes avec 12 Go de ram, vous aviez au total 12 Go de ram, et l'obligation d'envoyer les données 2x. Désormais, vous aurez 24 Go de ram, et ne devez envoyer les données qu'une seule fois. Chaque carte peut de plus écrire en même temps dans la même image.

L'air de rien, rien que ce nouveau pont permet d'enlever une des plus grosse limite qui obligeait les renderer offline à bosser sur un CPU (une scène 3d un peu lourde, avec textures, peut prendre 64 Go de mémoire par exemple). Ici, c'est un maximum de 96 Go de ram qui peut etre alloué au total.

Vient ensuite les performances, le prix et la place. Il est évident que la place prise par une CG est bien moindre qu'un serveur complet. Il est aussi fort probable que la consommation électrique est bien plus faible. Pour les performances, si une seule Quadro RTX éclate sans problème n'importe quel Xeon, il reste à voir dans quel rapport puissance/prix. Nvidia annonce ici 10 GigaRay/s, mais le calcul d'intersection n'est qu'une faible partie du processus de rendu. Il faut encore résoudre des équations complexes pour arriver à une image finale. Nvidia annonce, à prix égal, un facteur de gain de 3 à 4x par rapport à un rendu CPU, ce qui est déjà énorme.

Ouais mais bon et les jeux-vidéo ?

Ben le jeu-vidéo, il suit la voie, avec quelques années de retard, du précalculé. Les rendus de plus en plus réalistes des jeux actuels demandent des techniques de plus en plus sophistiquées, et de moins en moins adaptées au temps-réel. On se retrouve ici avec de plus en plus de maps d'illuminations et d'ombres pré-calculées, empêchant aux éléments de la scène 3d d'être mobiles et à l'éclairage d'être dynamique.Ici aussi, l'architecture Turing essaie de faire tabula-rasa des techniques ancestrales, et propose, en plus de l'accélération hardware de RTX, des cores dédiés à l'IA (les TensorCore introduits par Volta) et à l'inférence (application d'un apprentissage via deep learning), afin de palier aux problèmes de temps de rendu du ray-tracing : on rend à moindre résolution et avec moins de rayons, et le deep learning vient retirer le bruit (problème majeur d'une image ray-tracing de faible qualité). Le DLAA (Deep Learning AA) s'applique actuellement dans les rendus précalculés via Optix.

Résultat : Là où une carte Pascal avait besoin de 600ms pour rendre une image, une carte Turing n'aura besoin que de 30 ms. Et nous parlons ici d'image complexe qui pourrait passer pour du rendu offline. Une image plus simple demandant évidemment moins de temps.

Tout ceci concerne les cartes professionnelles de Nvidia (gamme Quadro). Vous vous demandez sans doute quand est-ce qu'on aura ça pour le gaming. Probablement dans plusieurs années pensez-vous. Et bien pour répondre à cette question, Nvidia a, en parallèle de son annonce, diffusé un petit teaser sur youtube, avec quelques indices sur une possible nouvelle carte Geforce.

Xtreme Ray, RTX not 11, gimme 20.. Et un utilisateur Mac-20 parlant à un Eight Tee (Eighty = 80).

Pour marquer le saut de technologie, il semblerait que NVidia passe de la dénomination GTX 10x0 à RTX 20x0. A moins que les deux gammes co-existent ? Dans tous les cas, réponse le 20 août à la Gamescom ! Sinon, quelqu'un a pensé à prendre des nouvelles d'AMD ? Il a fait un peu chaud ces derniers jours et on s'inquiète un peu...