ARTICLE

Du vin, du cash et du vin, c'est la 2080

par CBL,

email @CBL_Factor

par CBL,

email @CBL_Factor

La Gamescom se termine aujourd'hui et a été riche en annonces mais l'une d'entre elles a dominé l'actualité : celle de la nouvelle génération de cartes graphiques pour joueurs. Elle fait suite à l'annonce des cartes professionnelles et à l'explication du fonctionnement de la nouvelle architecture Turing. Pour l'instant, il y a trois cartes : la GeForce RTX 2080 Ti vendue $1200, la GeForce RTX 2080 vendue $800 et la GeForce RTX 2070 vendue $600. Mais la grande question est : qu'est-ce qu'elles ont dans le sac? Est-ce qu'elles font tourner Crysis?

Avant de commencer, il est important de préciser quelques détails techniques simples car Turing introduit des choses entièrement nouvelles pour cette génération. Comme toutes les puces depuis l'architecture Tesla (GeForce 8800), la 2080 Ti embarque une série de Streaming Multiprocessors. Elle en compte 68 et chacun embarque 64 CUDA cores de génération Turing pour un total de 4352. La nouveauté est que chacun embarque aussi 8 Tensor cores dédiés à l'apprentissage automatique pour un total de 544 ainsi que 1 Ray Tracing (RT) core dédié au ray-tracing pour un total de 68.Comme Nvidia aime compliquer les choses, ils ont introduit tout plein de nouvelles unités de mesures. En plus des TFLOPS (mille milliards d'opérations sur des nombres à virgule flottante par seconde) et de la bande passante mesurée en milliards d'octets transférés par seconde, il faut désormais compter sur les TIPS (mille millards d'opérations sur des entiers par seconde), les Giga Rays/s (milliards de rayons lancés par seconde) et une nouvelle unité appelée RTX-OPS qui est censée mesurer la puissance de calcul combinée de la carte sur tous les plans et qui nous semble assez arbitraire.

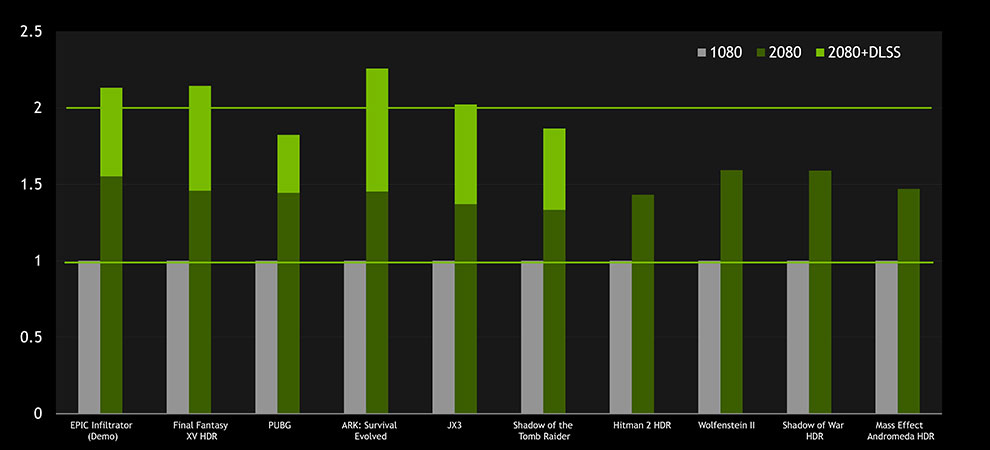

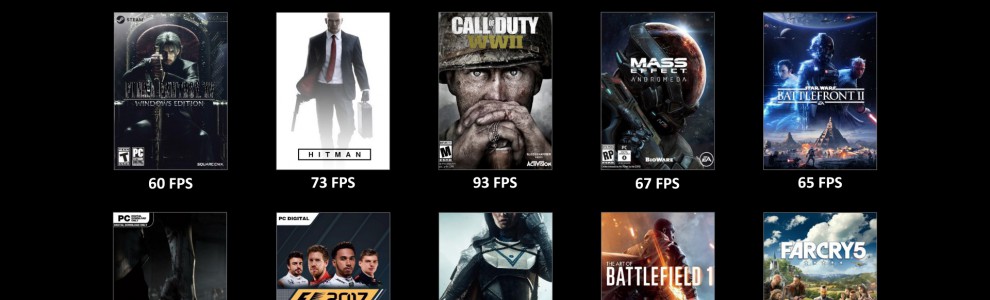

Tout cela est bien beau mais au final le joueur ne comprend qu'une seule unité : le nombre d'images par seconde ou framerate. L'ironie est que cette dernière est aussi arbitraire car elle dépend du niveau de détails et de la résolution. Nvidia a donc publié un premier benchmark de jeux actuels tournant en 4K avec la 2080 (non Ti) sans préciser le niveau de détails. Tous tournent au minimum à 60 FPS et le gain de perf comparé à une 1080 est en moyenne de 30% ce qui n'est pas énorme compte tenu du fait que la 2080 est vendue 60% plus cher que la 1080. Mais il est important de préciser que ces jeux ne sont pas optimisés pour Turing et c'est là où se fera la différence.

Commençons par le Deep Learning Super-Sampling ou DLSS (le nom officiel du DLAA). Actuellement, il existe différentes méthodes d'anti-aliasing mais elles ont toutes un point en commun : elles sont couteuses en temps GPU. Avec le DLSS, l'anti-aliasing n'est plus calculé par les CUDA cores : ce sont les Tensor cores qui font le boulot libérant ainsi la puissance des CUDA cores pour le reste. Grâce à cela, Nvidia annonce des performances doublées entre la 1080 et la 2080 pour les jeux supportant le DLSS. Le support ne se fait pas au niveau des pilotes donc les développeurs doivent implémenter le DLSS dans leur moteur. Nvidia s'est engagé à le faire gratuitement si les devs leur envoient leur code.

Ce n'est que le début. En théorie, les calculs d'IA peuvent aussi être déportés sur les Tensor cores libérant ainsi du temps CPU cette fois et il est même question d'utiliser l'apprentissage automatique pour rendre les cheveux. Il est aussi compliqué de mesurer les performances des Tensor cores mais Anandtech a développé un benchmark spécial pour l'occasion. Une autre optimisation possible se situe au niveau des shaders. A chaque cycle, chaque unité de calcul de Turing peut effectuer en parallèle une opération sur un nombre à virgule flottante (float) et une autre sur un entier (int - d'où les TIPS, pour Tera Integer operation Per Second). Le code des shaders utilise plus souvent les floats pour profiter de la plus grande précision des calculs mais Turing pourrait inciter les développeurs à revoir une partie de leur code pour basculer une partie sur les entiers.

Pour les RT cores, les choses sont plus compliquées. Les moteurs actuels utilisent la rastérisation pour le rendu et ne vont pas basculer vers le ray-tracing du jour au lendemain. Le ray-tracing va d'abord être ajouté pour les reflets et les ombres. Pixar a suivi le même chemin pour le rendu de ses films. Leur moteur de rendu, RenderMan, a utilisé d'abord la rastérisation. Avec Cars, Pixar a ajouté une dose de RT pour les reflets ds voitures puis est passé à la vitesse supérieure avec Monsters University. La conséquence pour le joueur est que pour l'instant les RT cores seront limités à rendre les ombres et les reflets plus jolis et plus réels via RTX, l'implémentation d'Nvidia de DXR (DirectX Raytracing).

Et là vous vous dites : "Hey mais ils ne sont pas en train de nous vendre un GameWorks bis ?". Si vous vous souvenez, GameWorks est une gamme d'effets et de techniques de rendus. En plus de ne pas être compatibles AMD, les effets sur les performances sont souvent désastreux. La réponse est "oui et non". Pour ce qui est du DLSS, c'est uniquement compatible Nvidia. AMD (ou autre) devra développer son propre algo pensé pour son équivalent des Tensor cores. Pour ce qui est des effets RTX, DXR est en théorie un standard. On a déjà expliqué que le DLSS produit un gain de perf'. Pour les effets RTX, les premiers jeux les utilisant comme Shadow Of The Tomb Raider ont pour l'instant du mal à tenir le 60 FPS en 1080p. Mais il faut préciser que la techno est super jeune, que les devs n'ont le kit de dev que depuis quelques semaines et que les moteurs ne sont pas pensés pour.

Il n'y a pas des masses de jeux qui supportent RTX et/ou DLSS mais on notera la présence de deux moteurs fondamentaux, Frostbite (EA) et Unreal Engine 4, ainsi que le support des grands noms comme Square Enix, IO Interactive ou Remedy. Battlefield V est particulièrement impressionnant et les effets RTX donnent même un avantage de gameplay car les reflets permettent de voir s'il n'y a pas un joueur derrière soi. Le problème n'est pas le support logiciel mais le support matériel. Pour l'instant AMD n'a pas encore annoncé de puces aux possibilités similaires. Histoire d'assurer la rétrocomp' avec la génération actuelle, il est fort possible que la PS5 et la Xbox 4 embarquent de l'AMD et les questions de prix nous laissent penser que la prochaine génération de consoles ne comportera pas de matos accélérant le RT ou l'apprentissage automatique. Du coup, le RT dans les jeux risque d'être cantonné quelques temps à des effets en plus sur les PCs haut de gamme. Mais au fond, cela a toujours été le cas.

La 2080 sera livrée aux alentours du 20 Septembre donc l'embargo devrait tomber en même temps. La 2080 Ti arrivera peu après et il faudra attendre Novembre pour la 2070. Si vous êtes chercheur et que vous avez besoin de traiter des gigatonnes de données, vous pouvez foncer sur la 2080 Ti. La puissance de calcul brute offerte par cette carte est sidérante. Idem si vous avez besoin d'un serveur de rendu à la maison pour vos scènes 3D.

Si vous êtes un joueur pur et dur et que vous avez déjà une carte haut de gamme de la précédente génération (voir une 980/980 Ti), il est sage d'attendre la prochaine génération de cartes et/ou l'optimisation des moteurs pour Turing. Il est aussi important d'attendre les benchmarks indépendants. L'arme secrète d'Nvidia pourrait être aussi la GeForce 2060, une carte milieu de gamme au rapport prix/performances délirant. Ce qui est sûr c'est que le prix des cartes graphiques est redevenu normal. La valeur des crypto-monnaies s'est effondrée et le minage sur GPU n'est plus rentable.

Si vous êtes un joueur pur et dur et que vous avez déjà une carte haut de gamme de la précédente génération (voir une 980/980 Ti), il est sage d'attendre la prochaine génération de cartes et/ou l'optimisation des moteurs pour Turing. Il est aussi important d'attendre les benchmarks indépendants. L'arme secrète d'Nvidia pourrait être aussi la GeForce 2060, une carte milieu de gamme au rapport prix/performances délirant. Ce qui est sûr c'est que le prix des cartes graphiques est redevenu normal. La valeur des crypto-monnaies s'est effondrée et le minage sur GPU n'est plus rentable.